El Centro de Regulación Genómica (CRG), la empresa Starlab y la Universidad de Barcelona (UB) presentaron un innovador sistema que convierte las ondas cerebrales de las emociones en sonidos, lo que permite comunicarse a personas con discapacidades profundas, como los afectados de parálisis cerebral.

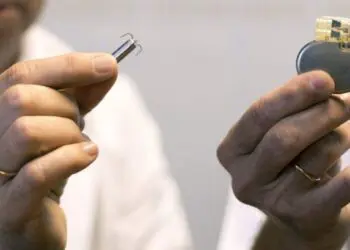

Este proyecto, llamado “Brain Polyphony”, consiste en un casco (“Enobio helmet”) que se coloca en la cabeza con neurosensores y medidores cardíacos que transmiten los impulsos eléctricos del cerebro, los latidos y la actividad muscular a un ordenador, que analiza la reacción emocional en tiempo real en función de unos parámetros previamente establecidos.

La responsable del proyecto, la científica del CRG, Mara Dierssen, explicó que este nuevo sistema “sonifica las emociones del paciente a través de la actividad eléctrica cerebral (EEG), cardíaca (ECG), muscular (EMG) y de acelerometría”.

Según la intensidad de las ondas cerebrales, el ritmo cardíaco, su variación o la actividad muscular, el aparato mide si una persona que no puede expresarse ni verbal ni físicamente siente emociones positivas (felicidad) o negativas (tristeza o enfado) en mayor o menor intensidad.

Según explicó Marcos Quevedo, investigador de CRG-IMIM, este sistema, que se está desarrollando desde marzo, ha sido ensayado con dos pacientes con discapacidad cerebral con buenos resultados.

Según cada caso, los investigadores deciden si se ha de utilizar el patrón EEG, ECG o EMG (o los tres a la vez), realizan un cálculo basal (registran cuál es el estado neutro del paciente) y, a partir de ahí, comienzan con el análisis de las reacciones registradas a partir de estímulos visuales y aditivos en el ordenador.

El investigador de Starlab David Ibáñez ha expresado la voluntad del equipo de “democratizar el proyecto y hacer uso de esta tecnología en un entorno real” para que la gente pueda utilizarlo en su casa.

El investigador del Barcelona Research Art & Creation de la UB, Efraín Foglia, afirmó que este sistema podría llegar a suplantar al cuidador físico de los pacientes con discapacidades, ya que “si el paciente es capaz de controlar respuestas básicas entonces puede llegar a modelar su entorno”.

“Brain Polyphony” se trata de un proyecto piloto que cuenta con un año vista para ser desarrollado y aplicado a 15 pacientes más para comprobar su rendimiento, tras el cual esperan poder disponer al menos de un aparato que funcione a pleno rendimiento.

EFE